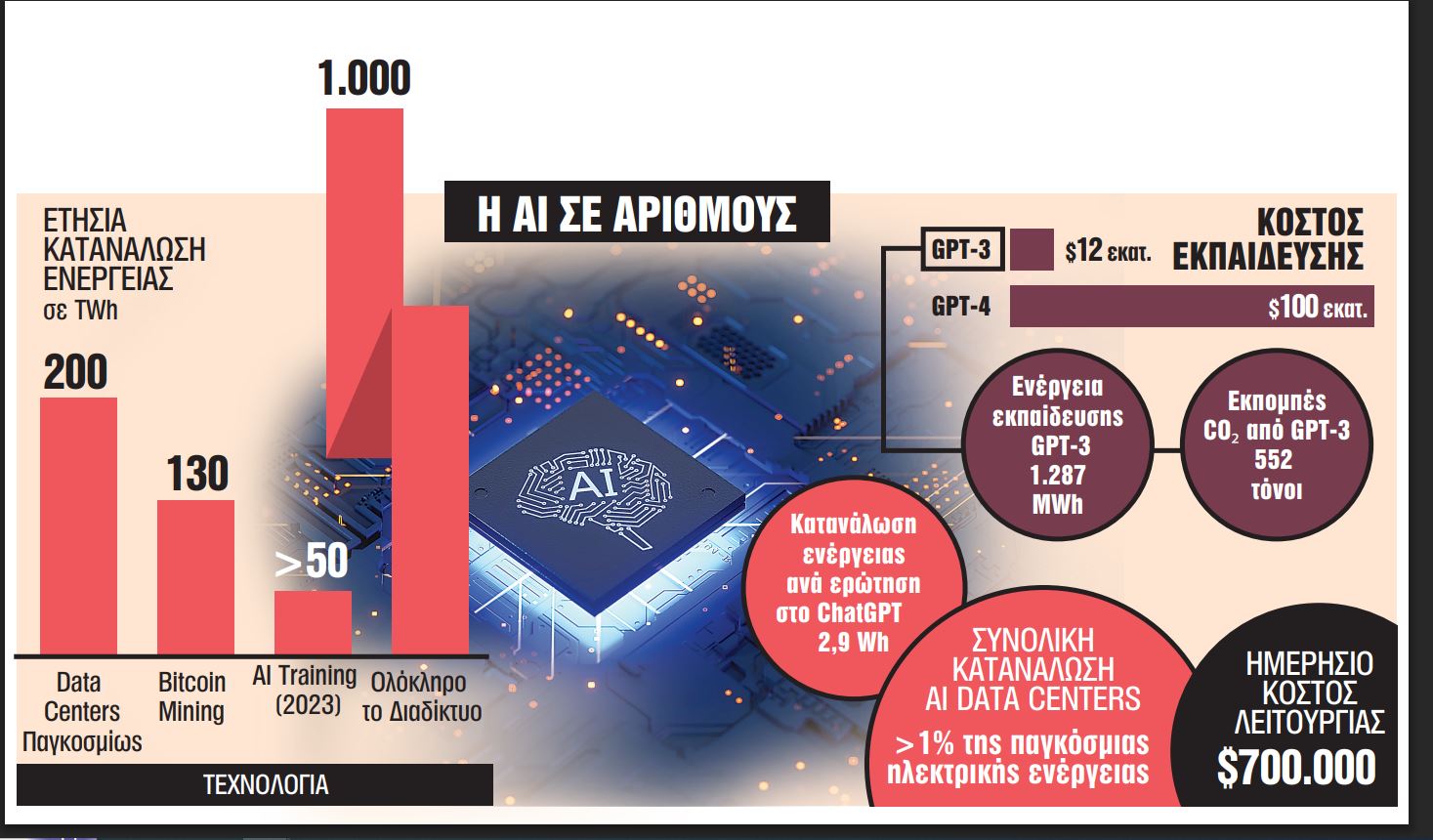

Καθώς τα AI μοντέλα γίνονται πιο πολύπλοκα, απαιτούν όλο και περισ-σότερους υπολογιστι-κούς πόρους, αυξάνοντας έτσι το κόστος ανάπτυξης, εκπαίδευσης και λειτου-ργίας τους

Οι επιστήμονες και οι άνθρωποί της το παραδέχονται: Η τεχνητή νοημοσύνη (AI) έχει φέρει επανάσταση σε πολλούς τομείς, από την υγεία και την οικονομία έως τη βιομηχανία και την καθημερινή μας ζωή.

Ωστόσο, πίσω από αυτή την τεχνολογική πρόοδο κρύβεται ένα σημαντικό κόστος, τόσο σε οικονομικούς πόρους όσο και σε ενεργειακή κατανάλωση.

Καθώς τα AI μοντέλα γίνονται πιο πολύπλοκα, απαιτούν όλο και περισσότερους υπολογιστικούς πόρους, αυξάνοντας έτσι το κόστος ανάπτυξης, εκπαίδευσης και λειτουργίας τους.

Το κόστος αυτό προέρχεται κυρίως από υπολογιστική ισχύ και hardware.

Τα προηγμένα μοντέλα AI απαιτούν ειδικό εξοπλισμό υψηλής απόδοσης, όπως γραφικούς επεξεργαστές (GPUs) και επιταχυντές Tensor Processing Units (TPUs).

Αυτά τα τσιπ είναι πολλαπλάσια ακριβότερα από τους συμβατικούς επεξεργαστές, ενώ η τιμή τους έχει αυξηθεί λόγω της μεγάλης ζήτησης.

Οι κορυφαίοι επεξεργαστές της NVIDIA, όπως οι A100 και H100, κοστίζουν από 10.000 έως 40.000 δολάρια ανά μονάδα.

Ενα σύστημα εκπαίδευσης AI μπορεί να απαιτεί χιλιάδες GPUs ή TPUs, εκτοξεύοντας το κόστος σε εκατομμύρια δολάρια.

Η εκπαίδευση ενός μοντέλου όπως το GPT-4 απαιτεί τεράστιες ποσότητες δεδομένων και υπολογιστικών πόρων.

Για παράδειγμα, η εκπαίδευση του GPT-3 (το προηγούμενο μοντέλο) κόστισε περίπου 12 εκατομμύρια δολάρια σε υπολογιστικό χρόνο.

Το GPT-4, όντας ακόμα πιο περίπλοκο, εκτιμάται ότι κόστισε πάνω από 100 εκατομμύρια δολάρια για την εκπαίδευσή του.

Αυτό καθιστά την ανάπτυξη AI απρόσιτη για πολλές μικρότερες εταιρείες, αφήνοντας την έρευνα και την ανάπτυξη στα χέρια λίγων τεχνολογικών κολοσσών, όπως η OpenAI, Google, Meta και Microsoft.

Οι εκτιμήσεις.

Ακόμα και μετά την εκπαίδευση, τα AI συστήματα απαιτούν τεράστια ποσά ενέργειας για να παραμείνουν λειτουργικά.

Κάθε αίτημα που γίνεται σε ένα chatbot όπως το ChatGPT καταναλώνει υπολογιστικούς πόρους, γεγονός που αυξάνει το λειτουργικό κόστος.

Σύμφωνα με εκτιμήσεις, το κόστος λειτουργίας ενός AI chatbot μεγάλης κλίμακας μπορεί να φτάσει τα 700.000 δολάρια την ημέρα.

Παράλληλα, οι εταιρείες επενδύουν δισεκατομμύρια δολάρια σε data centers, τα οποία καταναλώνουν μεγάλες ποσότητες ενέργειας.

Ενα από τα μεγαλύτερα μειονεκτήματα της AI είναι η τεράστια ενεργειακή κατανάλωση, η οποία έχει σημαντικό περιβαλλοντικό αντίκτυπο.

Η εκπαίδευση ενός μεγάλου γλωσσικού μοντέλου (LLM) όπως το GPT-3 ή το GPT-4 απαιτεί τεράστιες ποσότητες ηλεκτρικής ενέργειας.

Το GPT-3 κατανάλωσε περίπου 1.287 MWh ηλεκτρικής ενέργειας για την εκπαίδευσή του, ισοδύναμο με 100 αμερικανικά νοικοκυριά σε έναν χρόνο.

Το GPT-4 εκτιμάται ότι ξεπέρασε κατά πολύ αυτό το νούμερο. Πάντως, όχι μόνο η εκπαίδευση, αλλά και η καθημερινή χρήση των AI μοντέλων είναι ενεργοβόρα.

Κάθε ερώτηση που γίνεται στο ChatGPT μπορεί να καταναλώσει περίπου 2,9 Wh ενέργειας. Αν το ChatGPT απαντήσει σε 10 εκατομμύρια ερωτήσεις την ημέρα, αυτό ισοδυναμεί με την ημερήσια κατανάλωση ενέργειας μιας μικρής πόλης.

Η τεράστια ενεργειακή κατανάλωση μεταφράζεται σε υψηλές εκπομπές διοξειδίου του άνθρακα (CO₂). Το GPT-3 παρήγαγε περίπου 552 τόνους CO₂ κατά την εκπαίδευσή του.

Τα data centers που φιλοξενούν AI καταναλώνουν πάνω από 1% της παγκόσμιας ηλεκτρικής ενέργειας.